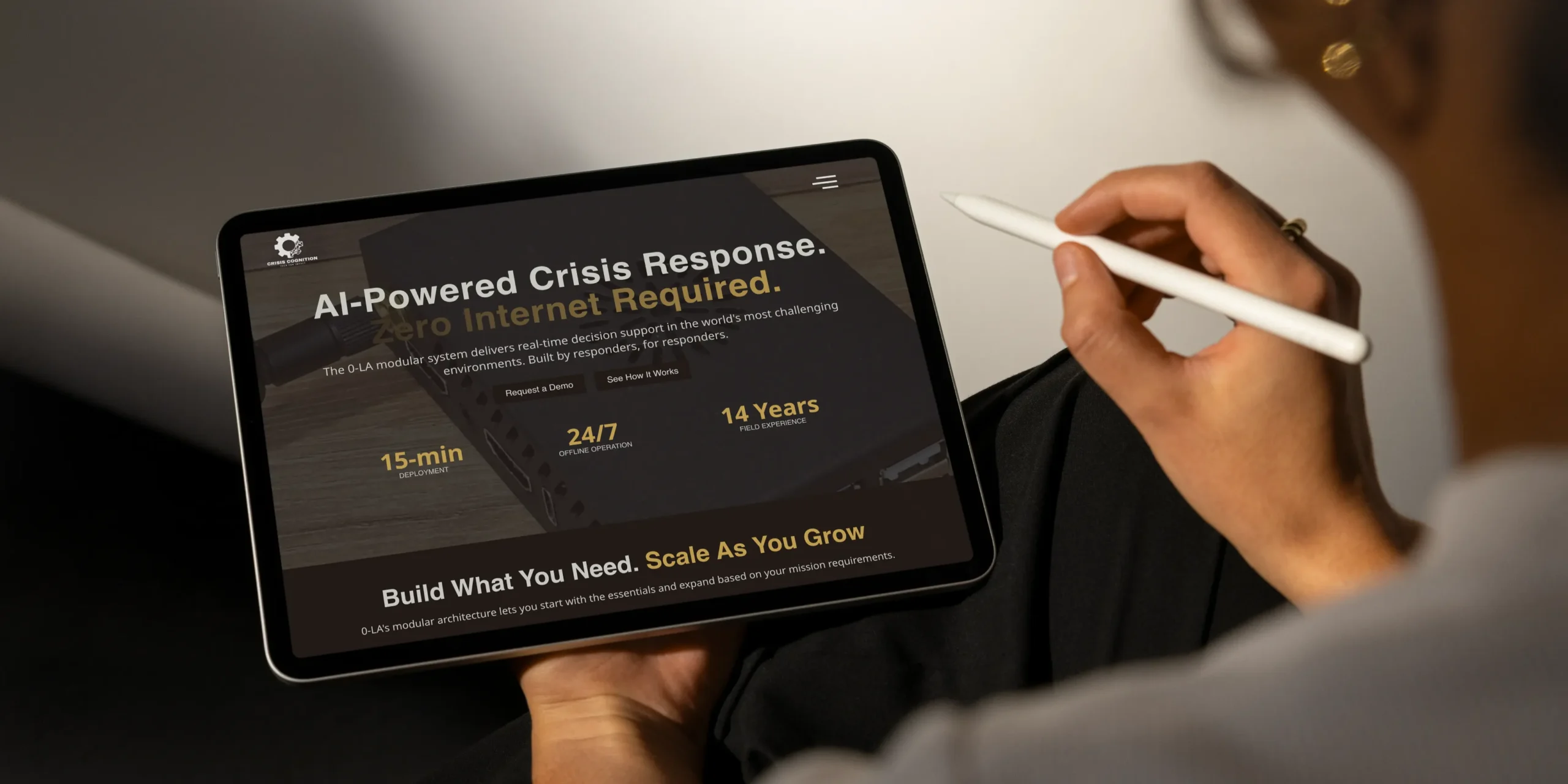

Offline AI-prototype voor crisisrespons, gebouwd voor Crisis Cognition

Samenvatting

WeAreBrain bouwde het eerste offline AI-prototype voor Crisis Cognition. Het draait lokaal op hardware met laag stroomverbruik, ondersteunt veldteams zonder internettoegang en bewijst dat geavanceerde taalmodellen kunnen werken in volledig losgekoppelde omstandigheden.

De uitdaging

Crisisresponsteams werken vaak op plekken waar connectiviteit onbetrouwbaar is of ontbreekt. Wanneer netwerken uitvallen, stoppen cloudtools met werken en vertraagt de besluitvorming. Crisis Cognition wil dit oplossen door een AI-assistent te ontwikkelen die offline blijft werken, waardoor responders snelle en betrouwbare ondersteuning krijgen in moeilijke omgevingen.

Om dit concept om te zetten in een werkend systeem, werkte Crisis Cognition samen met WeAreBrain. Ons team leverde het eerste operationele prototype van hun offline assistent. Het prototype bevestigt dat hoogwaardige taalmodellen lokaal kunnen draaien met lage latentie en zonder cloudafhankelijkheid. Het legt een sterke basis voor veldpilots en toekomstige iteraties.

Crisis Cognition draagt diepgaand veldinzicht bij en een missie gericht op responseffectiviteit. Wij leverden de techniek die nodig was om het idee praktisch te maken. Samen bouwden we een systeem ontworpen om teams te helpen snel te handelen en geïnformeerd te blijven wanneer communicatielijnen uitvallen.

Stap-voor-stap proces

-

Lokale netwerkopzet

We configureerden de Orange Pi 5 Max als Wi-Fi Access Point. Dit maakt het mogelijk dat telefoons, tablets en laptops direct verbinding maken zonder externe infrastructuur. Het ondersteunt gebruik in afgelegen of verstoorde gebieden.

-

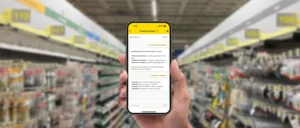

Captive portal

Een Captive Portal zorgt ervoor dat elk verbonden apparaat automatisch wordt doorgestuurd naar de Open WebUI-interface. Dit elimineert setup-frictie en laat responders de assistent direct gebruiken.

-

End-to-end integratie

Het uiteindelijke systeem werkt als een op zichzelf staande eenheid. Het model draait lokaal, de UI laadt via het Wi-Fi-netwerk van het apparaat, en de gebruiker kan queries uitvoeren zonder internettoegang of clouddiensten.

Dit prototype toont aan dat offline AI haalbaar is op compacte hardware met laag stroomverbruik. Het ondersteunt Crisis Cognition’s doel om responders uit te rusten met beslissingsondersteunende tools waarop ze kunnen vertrouwen wanneer infrastructuur het laat afweten.

Het resultaat

Het prototype bevestigt het volgende:

- LLM’s kunnen betrouwbaar draaien op de RK3588 NPU

- Offline inferentie is levensvatbaar voor crisisomgevingen

- Een volledig op zichzelf staande AI-assistent kan opereren zonder clouddiensten

- Lage latentie responses zijn haalbaar binnen hardwarebeperkingen

- Niet-technische gebruikers kunnen het systeem benaderen via een eenvoudige UI

Voor een gedetailleerd architectuuroverzicht of om potentiële samenwerking te verkennen, neem contact op met WeAreBrain.

Als je een NGO of humanitaire ondersteuningsorganisatie vertegenwoordigt, neem contact op met het team van Crisis Cognition.

Gebruikte technologie en hardware

Het prototype moest AI-modellen draaien zonder internettoegang, lokale inferentie afhandelen en betrouwbaar blijven onder beperkte stroom of instabiele omstandigheden. We selecteerden hardware en software die deze vereisten ondersteunen.

- Hardware

We gebruikten de Orange Pi 5 Max single-board computer met de RK3588-processor en geïntegreerde NPU. Deze hardware levert efficiënte on-device inferentie voor taalmodellen. Een Micro SD-kaart werd toegevoegd voor lokale opslag van modelbestanden en operationele data. - Besturingssysteem

Het apparaat draait Armbian OS, een lichtgewicht Linux-distributie geoptimaliseerd voor ARM-gebaseerde boards. Het biedt stabiliteit, voorspelbare prestaties en een goede basis voor verdere aanpassing. - LLM runtime en model

Om het model lokaal uit te voeren, gebruikten we rkllm, een runtime ontworpen voor de RK3588 NPU. We breidden deze runtime uit in onze eigen repository.

Het geselecteerde model is Qwen2.5-3B-Instruct, geoptimaliseerd voor deze chip. Het biedt een goede balans tussen nauwkeurigheid, snelheid en geheugengebruik. Het model reageert snel, zelfs wanneer hardwarebronnen beperkt zijn. - Gebruikersinterface

Om responders een eenvoudige manier te geven om met het systeem te interacteren, implementeerden we Open WebUI. We pasten het aan in onze GitHub-repository. De interface draait in een browser, wat het systeem gemakkelijk maakt om in het veld te gebruiken.